3.9分钟训完GPT-3,英伟达H100再次刷新MLPerf六项纪录,创造新纪元!

更新时间:2023-11-09 14:40:40作者:kzmyhome

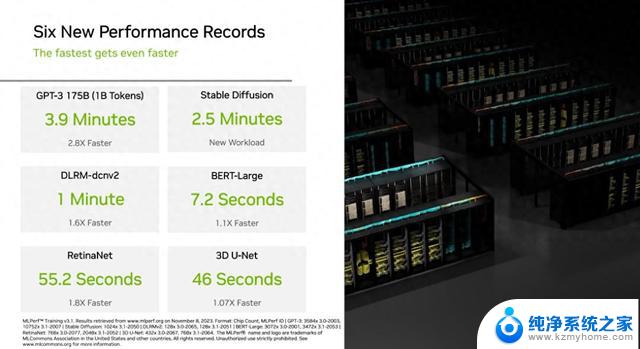

11 月 9 日消息,英伟达今天发布新闻稿。表示旗下的 H100 GPU 在 MLPerf 基准测试中创造了 6 项新记录。

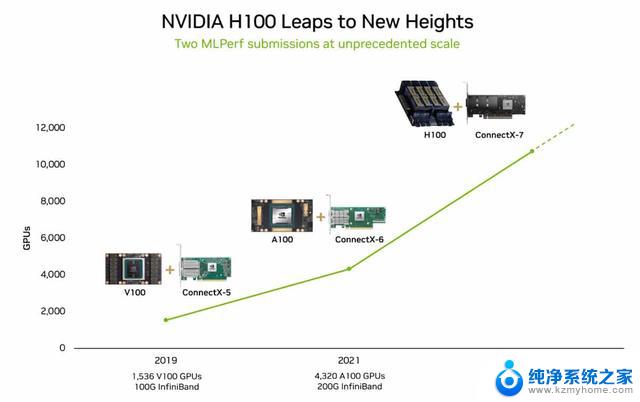

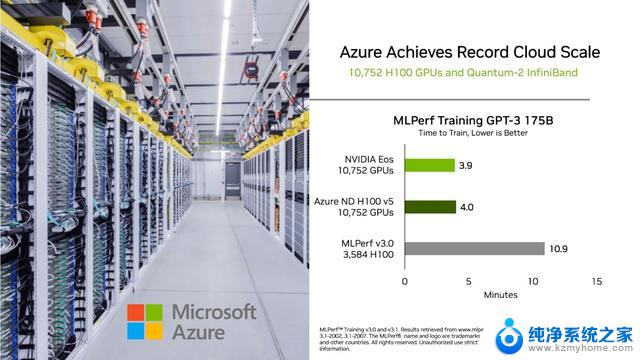

今年 6 月报道,3584 个 H100 GPU 群在短短 11 分钟内完成了基于 GPT-3 的大规模基准测试。

MLPerf LLM 基准测试是基于 OpenAI 的 GPT-3 模型进行的,包含 1750 亿个参数。

Lambda Labs 估计,训练这样一个大模型需要大约 3.14E23 FLOPS 的计算量。

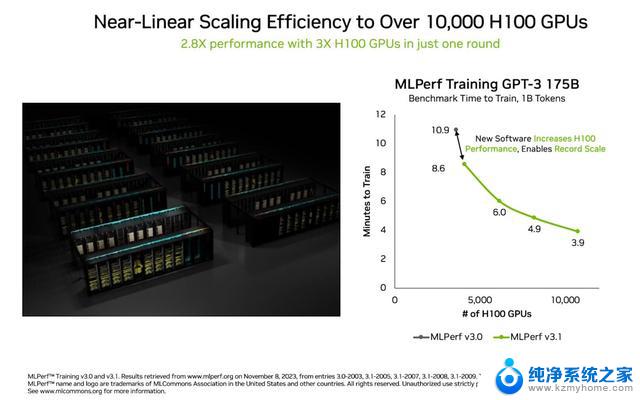

英伟达最新的 Eos AI 超级计算机配备了 10752 个 H100 Tensor Core GPU 和 NVIDIA 的 Quantum-2 InfiniBand 网络,训练完 GPT-3 仅仅只需要 3.9 分钟,比 6 月的测试结果整整快了 7 分钟。

英伟达在帖中,的另一项创纪录的成就是在“系统扩展”方面取得的进步,通过各种软件优化,效率提高到了 93%。

高效扩展在行业中非常重要,因为实现高计算能力需要使用更多的硬件资源。如果没有足够的软件支持,系统的效率会受到大幅影响。

3.9分钟训完GPT-3,英伟达H100再次刷新MLPerf六项纪录,创造新纪元!相关教程

- 英伟达创纪录!AI芯片巨头成为标普500最大盈利贡献者

- 英伟达再战移动掌机,这次要靠AI逆风翻盘?最新动态揭秘

- 英伟达公布RTX 40显卡CS2性能表现:RTX 4090 543fps,刷新了性能极限!

- 道指涨超200点,微软、英伟达创收盘历史新高!中概股大涨!

- 禁令升级!英伟达停止供应顶级显卡,华为再次承受压力

- NVIDIA开源GPU驱动:性能并驾齐驱,开创技术新纪元——性能表现堪比闭源驱动

- 因为英伟达,半导体行业步入“新战国时代”?英伟达如何推动半导体行业进入新时代

- 消息称英伟达将推RTX 4080 Ti显卡,与4080同价-最新英伟达4080 Ti显卡消息

- 英伟达H100 GPU今年流向微软和Meta,两家成为最大买家

- 新一轮巴以冲突冲击科技业:英伟达取消AI峰会

- 如何安全拆卸显卡的详细步骤与注意事项,让你轻松拆解显卡!

- 英伟达对AI的理解和布局,黄仁勋在这里讲清楚了:探索英伟达在人工智能领域的战略布局

- 微软未来将继续推出Xbox硬件,掌机设备蓄势待发最新消息

- AMD锐龙AI 9 HX 370游戏性能领先酷睿Ultra 7 258V 75%

- AMD裁员上千人,市场“吓坏”!英伟达会超越吗?

- Win11 23H2用户反馈微软11月更新导致错误显示“终止支持”问题解决方案

微软资讯推荐

- 1 详细教程:如何在电脑上安装Win7系统步骤解析,零基础教学,轻松搞定安装步骤

- 2 如何查看和评估电脑显卡性能与参数?教你如何正确选择电脑显卡

- 3 微软酝酿Win11新特性:图表显示过去24小时PC能耗数据

- 4 倒计时!Windows 10要“退休”啦,微软官方支持即将结束,升级Windows 11前必读!

- 5 Windows 11 的 8个令人头疼的细节及解决方法 - 如何应对Windows 11的常见问题

- 6 AMD Zen 6架构台式机处理器将保留AM5兼容性,预计最快于2026年末发布

- 7 微软技术许可有限责任公司获得自动恶意软件修复与文件恢复管理专利

- 8 数智早参|微软斥资近百亿美元租用CoreWeave服务器,加速云计算发展

- 9 Win10 如何优化系统性能与提升使用体验?教你简单有效的方法

- 10 你中招了吗?Win11 24H2离谱BUG又来了,如何应对Win11最新版本的问题

win10系统推荐

系统教程推荐

- 1 u盘作为启动盘之后怎么还原 u盘启动盘变回普通u盘方法

- 2 wallpaper壁纸如何设置锁屏 锁屏壁纸设置方法

- 3 电脑f12截图默认保存在哪里 steamf12截图保存路径

- 4 液晶电视连wifi怎么看电视台 电视怎么连接wifi

- 5 不在一个网段如何共享打印机 局域网之外如何连接共享打印机

- 6 怎么取消桌面广告 win10如何关闭桌面弹出广告

- 7 电脑睡眠 快捷键 Windows 10 快速睡眠设置方法

- 8 如何打开avi格式视频 Windows Media Player播放avi教程

- 9 电脑怎么连接小米音响 小米蓝牙音响如何在win10上连接

- 10 打印机插电脑上怎么打印不了 打印机连接电脑无法打印解决方法